Uma das características mais interessantes dos dados que temos acesso no mundo moderno é justamente como é fácil mentir falando a verdade. Um exemplo: é perfeitamente possível um gestor dar um aumento a um orgão que na realidade se traduz como redução.

Sim, pode parecer contraditório, mas é bem real. Como as despesas são divididas em diversas rubricas, é possível aumentar em uma rubrica e diminuir em outra causando uma diminuição ao invés de um aumento (ou o reverso).

Por exemplo: a rubrica de custeio é substancialmente mais usada que a rubrica de bens de capital. Pode-se aumentar a rubrica de bens de capital (dobra-la até), e diminuir a de custeio. Dependendo da diminuição do custeio, o aumento da rubrica de bens de capital pode fazer pouca diferença (e temos de lembrar que bens de capital precisam ser comprados, via de regra através de licitação e devem atender uma série de regras bastante estritas).

Este tipo de mentira, aonde se fala parte da verdade, é possivelmente a mais comum que se vê em noticiários, programas políticos, discursos e planos de metas. É primariamente uma mentira, mas uma mentira embrulhada na verdade inegável.

Então temos vários exemplos: o parlamentar é seu representante, a qualidade subiu, a qualidade caiu, a bolsa subiu, a bolsa caiu e assim vai... No caso o parlamentar é seu representante mesmo, mas a questão é se ele está atuando como tal. Em um sistema representativo, seu representante deve defender os interesses das pessoas que o colocaram lá. Se ele não faz isto, então está sendo um mau representante.

No caso da qualidade subiu ou caiu. O que subiu? É quantitativo ou qualitativo? Se é quantitativo, qual o percentual de alteração? Se é qualitativo, quantas pessoas foram consultadas? E o mais importante: como é definida esta qualidade e como se pode ter certeza da evolução histórica da mesma?

No caso da bolsa: o que caiu ou subiu é o indicador da bolsa. E o mesmo trata de uma média das diversas operações. Sem conhecer a variância (ou desvio padrão), este indicador conta muito pouco da história real do que aconteceu (foram muitas ou poucas ações? A queda ou subida foi concentrada ou distribuída?)

Todas estas afirmações são forma de contar a verdade de modo incompleto, ou seja de mentir sem estar exatamente mentindo.

Este blog tem como propósito sincero esclarecer as notícias e novidades sem confundir.

domingo, 27 de fevereiro de 2011

Argumentos ignorantes, ou argumentador ignorante?

Sabe aquela conversa em que a pessoa é intransigente na sua opinião e apresenta argumentos aparentemente inquestionáveis, porém com pouca profundidade?

Geralmente esta pessoa não sabe direito sobre o que está falando.

Parece paradoxal, mas em geral os mais intransigentes na defesa não são os que mais entendem sobre o assunto, mas os que menos entendem sobre o assunto e passaram a defender esta ou aquela posição em função da paixão no assunto.

As pessoas com maior entendimento são, via de regra, bastante cautelosas em afirmações definitivas ou certezas absolutas. Por que? Bem, porque estes absolutos realmente não existem. Se o assunto é água potável, eles sabem que há muitas perguntas ainda sem resposta. Se a questão é o aquecimento global, os especialistas sabem que modelos computacionais são muito limitados em certos aspectos e que sua resposta é tão boa quanto a qualidade de dados de entrada (esta questão é polêmica, pois como métodos estatísticos são usados há mais perguntas do que respostas - mais sobre isto depois).

E este não é o único assunto. A decomposição de produtos industriais é algo que não está muito claro. E temos de lembrar que o nosso planeta já foi substancialmente mais inóspito do que hoje em passado não muito distante e ele se recuperou sem problemas.

Mas o maior perigo deste tipo de fanatismo da argumentação é que o mesmo não tem espaço para dúvidas ou incertezas - elementos fundamentais de toda boa evolução científica. E, naturalmente, este tipo de racionacilidade faz as perguntas erradas e escolhe as respostas erradas (se você não acredita que existam perguntas erradas, basta pensar em perguntas baseadas em correlações e não efeitos causa e efeito).

Uma das boas experiências que tive ao trabalhar em métodos númericos foi conhecer quão limitados os mesmos podem ser e quão precisos eles também podem ser. Muito bem: qual é a resolução espacial de uma simulação climática global? E a temporal? Será que ao escolhermos estas escalas, não estamos perdendo informações potencialmente relevantes para simulação climática?

Em tese, a outra parte do que irei mencionar agora trata exatamente da quantificação destas variáveis desconhecidas e incontroláveis: técnicas estatísticas. E realmente é verdade, o uso de probabilidade e suas distribuições podem suprir o desconhecimento de diversas variáveis. Mas há um porém: enquanto a probabilidade atua como uma medida do nosso desconhecimento, ela também necessita de caracterização adequada. A escolha equivocada de distribuições ou de coeficientes de correlação pode transformar um resultado da água para o vinho.

Há vários "benchmarks" a serem atingidos antes de termos certeza da qualidade das nossas simulações. Um deles é justamente se fenômenos aleatórios irão ou não desenvolver a mesma distribuição observada em dados reais.

Se não desenvolverem, então tem algo errado.

Geralmente esta pessoa não sabe direito sobre o que está falando.

Parece paradoxal, mas em geral os mais intransigentes na defesa não são os que mais entendem sobre o assunto, mas os que menos entendem sobre o assunto e passaram a defender esta ou aquela posição em função da paixão no assunto.

As pessoas com maior entendimento são, via de regra, bastante cautelosas em afirmações definitivas ou certezas absolutas. Por que? Bem, porque estes absolutos realmente não existem. Se o assunto é água potável, eles sabem que há muitas perguntas ainda sem resposta. Se a questão é o aquecimento global, os especialistas sabem que modelos computacionais são muito limitados em certos aspectos e que sua resposta é tão boa quanto a qualidade de dados de entrada (esta questão é polêmica, pois como métodos estatísticos são usados há mais perguntas do que respostas - mais sobre isto depois).

E este não é o único assunto. A decomposição de produtos industriais é algo que não está muito claro. E temos de lembrar que o nosso planeta já foi substancialmente mais inóspito do que hoje em passado não muito distante e ele se recuperou sem problemas.

Mas o maior perigo deste tipo de fanatismo da argumentação é que o mesmo não tem espaço para dúvidas ou incertezas - elementos fundamentais de toda boa evolução científica. E, naturalmente, este tipo de racionacilidade faz as perguntas erradas e escolhe as respostas erradas (se você não acredita que existam perguntas erradas, basta pensar em perguntas baseadas em correlações e não efeitos causa e efeito).

Uma das boas experiências que tive ao trabalhar em métodos númericos foi conhecer quão limitados os mesmos podem ser e quão precisos eles também podem ser. Muito bem: qual é a resolução espacial de uma simulação climática global? E a temporal? Será que ao escolhermos estas escalas, não estamos perdendo informações potencialmente relevantes para simulação climática?

Em tese, a outra parte do que irei mencionar agora trata exatamente da quantificação destas variáveis desconhecidas e incontroláveis: técnicas estatísticas. E realmente é verdade, o uso de probabilidade e suas distribuições podem suprir o desconhecimento de diversas variáveis. Mas há um porém: enquanto a probabilidade atua como uma medida do nosso desconhecimento, ela também necessita de caracterização adequada. A escolha equivocada de distribuições ou de coeficientes de correlação pode transformar um resultado da água para o vinho.

Há vários "benchmarks" a serem atingidos antes de termos certeza da qualidade das nossas simulações. Um deles é justamente se fenômenos aleatórios irão ou não desenvolver a mesma distribuição observada em dados reais.

Se não desenvolverem, então tem algo errado.

Atacar aonde dói

Se você já esteve em debates em foruns na internet, então provavelmente conhece casos aonde um dos debatedores passou a atacar ferozmente o outro.

Aqui eu não estou interessado no que gerou o ataque, mas no ataque em si. Imagine-se na posição do atacante, agora imagine que você não sabe nada sobre o atacado. Então qual seriam os pontos que você levantaria para atacar?

Bem, antes de continuar tenho de fazer uma ressalva: não estou supondo um ataque de idéias, mas um ataque na pessoa. O ataque de idéias se concentraria nos pontos fracos ou dúbios das idéias apresentadas para derrubar o argumento geral.

Aqui eu estou falando do ataque na pessoa mesmo. E mais ainda: suponho que o atacante não conheça exatamente o atacado. Isto é muito mais comum, pois via de regra para pessoas que se conhecem bem é mais raro chegar-se a esse nível de baixaria.

Muito bem, então se não se conhece bem o atacado sabe como é o ataque mais comum? Reciprocidade, ou seja, normalmente os pontos que são atacados são precisamente os pontos mais sensíveis do atacante.

Por que isso? Bom, alguma observação adequada pode convencê-lo da validade desta relação. Mas vamos ao caso mais prático: um ataque pessoal tem a finalidade de envergonhar, embaraçar ou mesmo desacreditar um debatedor. Mas como ter sucesso no ataque pessoal em quem não se conhece? Bem, não há garantias de sucesso, mas em primeira aproximação, pode-se atacar ao que se conhece - e supor que esta característica está presente no atacado.

Isto é bem irônico, pois este tipo de ataque revela mais sobre o atacante do que sobre o atacado, mas para uma primeira aproximação é uma suposição razoável. Isto envolve identificar no atacado características que sejam particularmente desagradáveis - que em geral o atacante conhece bem.

Do lado do atacado, se o mesmo se mantiver calmo e com sangue frio, esta argumentação é perfeita para se virar a mesa no atacante. Afinal, o atacante está de um modo ou de outro demonstrando pontos fracos em si. Em debates mais qualificados, este tipo de ataque pode servir como isca para envolver o adversário em armadilhas, mas isto requer um conhecimento bastante qualificado do adversário. Afinal, se o mesmo não morder a isca e tomar uma posição moral a estratégia pode ir por água abaixo.

E então vamos a exemplos: se o atacante chama as opinões de partidárias, é bem provável que isto indique que a posição dele é partidária. Se ele chama o adversário de burguês riquinho, então é bem provável que ele se sinta nesta situação. Se ele chama o adversário de despreparado, então é capaz que ele se veja nesta posição.

Então, o insulto também revela algo sobre quem insulta. Portanto, que for insultado de graça pode ter formas bem interessantes de revidar a altura. E quem ataca deveria pensar duas vezes antes de insultar.

Aqui eu não estou interessado no que gerou o ataque, mas no ataque em si. Imagine-se na posição do atacante, agora imagine que você não sabe nada sobre o atacado. Então qual seriam os pontos que você levantaria para atacar?

Bem, antes de continuar tenho de fazer uma ressalva: não estou supondo um ataque de idéias, mas um ataque na pessoa. O ataque de idéias se concentraria nos pontos fracos ou dúbios das idéias apresentadas para derrubar o argumento geral.

Aqui eu estou falando do ataque na pessoa mesmo. E mais ainda: suponho que o atacante não conheça exatamente o atacado. Isto é muito mais comum, pois via de regra para pessoas que se conhecem bem é mais raro chegar-se a esse nível de baixaria.

Muito bem, então se não se conhece bem o atacado sabe como é o ataque mais comum? Reciprocidade, ou seja, normalmente os pontos que são atacados são precisamente os pontos mais sensíveis do atacante.

Por que isso? Bom, alguma observação adequada pode convencê-lo da validade desta relação. Mas vamos ao caso mais prático: um ataque pessoal tem a finalidade de envergonhar, embaraçar ou mesmo desacreditar um debatedor. Mas como ter sucesso no ataque pessoal em quem não se conhece? Bem, não há garantias de sucesso, mas em primeira aproximação, pode-se atacar ao que se conhece - e supor que esta característica está presente no atacado.

Isto é bem irônico, pois este tipo de ataque revela mais sobre o atacante do que sobre o atacado, mas para uma primeira aproximação é uma suposição razoável. Isto envolve identificar no atacado características que sejam particularmente desagradáveis - que em geral o atacante conhece bem.

Do lado do atacado, se o mesmo se mantiver calmo e com sangue frio, esta argumentação é perfeita para se virar a mesa no atacante. Afinal, o atacante está de um modo ou de outro demonstrando pontos fracos em si. Em debates mais qualificados, este tipo de ataque pode servir como isca para envolver o adversário em armadilhas, mas isto requer um conhecimento bastante qualificado do adversário. Afinal, se o mesmo não morder a isca e tomar uma posição moral a estratégia pode ir por água abaixo.

E então vamos a exemplos: se o atacante chama as opinões de partidárias, é bem provável que isto indique que a posição dele é partidária. Se ele chama o adversário de burguês riquinho, então é bem provável que ele se sinta nesta situação. Se ele chama o adversário de despreparado, então é capaz que ele se veja nesta posição.

Então, o insulto também revela algo sobre quem insulta. Portanto, que for insultado de graça pode ter formas bem interessantes de revidar a altura. E quem ataca deveria pensar duas vezes antes de insultar.

sexta-feira, 25 de fevereiro de 2011

Mapa da violência

Este é o mapa da violência no Brasil segundo o instituto sangari.

O que se pode tirar dele? Bem São Paulo teve uma grande redução no número de homicídios de 1998-2008. Esta redução foi maior que as demais capitais. E portanto, apesar da nossa percepção, o número de homicídios em Rio, SP e Brasília diminuiu nos últimos 10 anos.

Outro ponto é que o número de homicídios diminuiu consistentemente a partir de 2003. O que aconteceu em 2003? A posse do governo do PT na presidência. Mas ao mesmo tempo, temos que a queda da violência é um fenômeno ponderado, sendo que pelas taxas envolvidas é possível que grande parte dessa queda se deva a estados específicos (RJ, SP)...

Para se ter mais certeza temos de ver as séries históricas e verificar se este número é uniformemente distribuído ou não. Olhando com cuidado no site , vemos que esta queda é fruto da queda no Rio de Janeiro (queda de 3350 em 2003 para 2204 em 2007) e em São Paulo (queda de 5591 em 2003 para 1927 em 2007). Portanto a queda no número de homicídios foi causada principalmente pela queda no Rio e em São Paulo.

segunda-feira, 21 de fevereiro de 2011

Teoria Matemática de Cidades?

Parece que os físicos resolveram entrar nos mais diversos campos com vontade. Geoffrey West e Luis Bettencourt resolveram estudar a física por trás das cidades.

E adivinhem? Tiveram sucesso...

Recomendo aos interessados a leitura do artigo original e do texto do Dr. West.

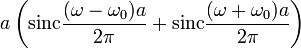

A equação é esta:

Isto é potencialmente extraordinário.

E adivinhem? Tiveram sucesso...

Recomendo aos interessados a leitura do artigo original e do texto do Dr. West.

A equação é esta:

Isto é potencialmente extraordinário.

Ondas de Tráfego

Eu já havia lido sobre o estudo do tráfego como uma onda, mas me deparei com um vídeo bastante interessante que parece confirmar algumas suspeitas que eu já tinha.

Primeira suspeita: é sempre melhor evitar freiar, para tanto temos de manter sempre uma distância apropriada do carro na nossa frente. O objetivo é evitar o efeito "stop-and-go" que os engarrafamentos possuem e que caracteriza a onda de tráfego.

Segunda suspeita: o instinto egoísta deve ser combatido nos trânsito. Contrário ao que parece, evitar que pessoas "espertas" tomem lugares vazios no trânsito tende a diminuir o fluxo ao invés de aumenta-lo. Claro que desde que se mantenha distância apropriada ao carro da frente.

*****************************************

Post Scriptum

O Prof. Paulo César mandou um excelente link que coloco aqui. O mesmo trata do artigo que descreve a teoria de ondas de tráfego.

Primeira suspeita: é sempre melhor evitar freiar, para tanto temos de manter sempre uma distância apropriada do carro na nossa frente. O objetivo é evitar o efeito "stop-and-go" que os engarrafamentos possuem e que caracteriza a onda de tráfego.

Segunda suspeita: o instinto egoísta deve ser combatido nos trânsito. Contrário ao que parece, evitar que pessoas "espertas" tomem lugares vazios no trânsito tende a diminuir o fluxo ao invés de aumenta-lo. Claro que desde que se mantenha distância apropriada ao carro da frente.

*****************************************

Post Scriptum

O Prof. Paulo César mandou um excelente link que coloco aqui. O mesmo trata do artigo que descreve a teoria de ondas de tráfego.

domingo, 20 de fevereiro de 2011

Competição - determinismo ou acaso?

Até aonde vai a sorte e até aonde vai a competência? Olhando para diversos exemplos não posso deixar de pensar no ditado "A sorte favorece os preparados". Ou seja, há sorte em obter uma oportunidade, mas há competência em mante-la.

Não posso deixar de pensar em quanto o acaso é presente na vida de todos. Ao mesmo tempo que todos nos preparamos da melhor forma para alcançar nossos objetivos, a obtenção final pode estar nas mãos do acaso puro e simples.

Prefiro pensar que temos a combinação de acaso e determinismo. Não temos apenas um, nem apenas o outro. Isto torna a vida impossível de predizer e preserva todos do pesadelo de "tudo já foi escrito".

Naturalmente, o que chamamos de acaso pode ser no final apenas o resultado da combinação de uma multitude de processos dos quais temos muito pouco conhecimento. Então as probabilidades de ocorrência de eventos passam a ser graus de desconhecimento.

Um exemplo de um sistema combinando acaso e determinismo: um campeonato de cara ou coroa. Vamos dizer que 64 pessoas concorram. Na primeira rodada 32 são eliminadas aleatoriamente, na segunda 16, na terceira 8, nas quartas de final 4, na semifinal 2 e na final apenas 1 sobrará.

A chance de uma pessoa ganhar é precisamente 1 em 64, mas vai haver uma pessoa que irá acertar todas as caras ou coroas que aparecerem no torneio. Sempre haverá um vencedor.

No entanto, se ao invés de chances iguais para cada 1, existirem um ou mais competidores com maior chance, então haverá maior probabilidade de um destes competidores se tornar campeão. É algo assim que imagino em jogos mais complexos - os competidores que possuírem maior chance provavelmente chegarão à final.

Naturalmente, devido a natureza aleatória deste jogo em particular não é improvável que alguém com menor chance chegue a final.

Talvez seja mesmo sorte

Não posso deixar de pensar em quanto o acaso é presente na vida de todos. Ao mesmo tempo que todos nos preparamos da melhor forma para alcançar nossos objetivos, a obtenção final pode estar nas mãos do acaso puro e simples.

Prefiro pensar que temos a combinação de acaso e determinismo. Não temos apenas um, nem apenas o outro. Isto torna a vida impossível de predizer e preserva todos do pesadelo de "tudo já foi escrito".

Naturalmente, o que chamamos de acaso pode ser no final apenas o resultado da combinação de uma multitude de processos dos quais temos muito pouco conhecimento. Então as probabilidades de ocorrência de eventos passam a ser graus de desconhecimento.

Um exemplo de um sistema combinando acaso e determinismo: um campeonato de cara ou coroa. Vamos dizer que 64 pessoas concorram. Na primeira rodada 32 são eliminadas aleatoriamente, na segunda 16, na terceira 8, nas quartas de final 4, na semifinal 2 e na final apenas 1 sobrará.

A chance de uma pessoa ganhar é precisamente 1 em 64, mas vai haver uma pessoa que irá acertar todas as caras ou coroas que aparecerem no torneio. Sempre haverá um vencedor.

No entanto, se ao invés de chances iguais para cada 1, existirem um ou mais competidores com maior chance, então haverá maior probabilidade de um destes competidores se tornar campeão. É algo assim que imagino em jogos mais complexos - os competidores que possuírem maior chance provavelmente chegarão à final.

Naturalmente, devido a natureza aleatória deste jogo em particular não é improvável que alguém com menor chance chegue a final.

Talvez seja mesmo sorte

sábado, 19 de fevereiro de 2011

quinta-feira, 17 de fevereiro de 2011

Projeções

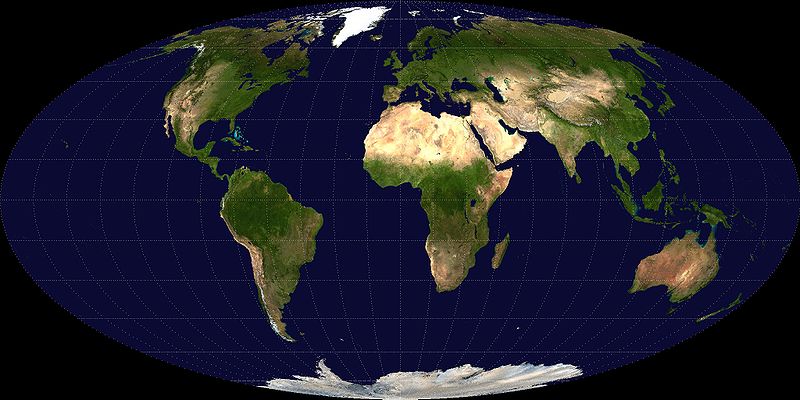

Um problema clássico de geografia (e matemática) é de como representar a superfície de uma esfera em um plano. Para encurtar: como fazer mapas.

No caso, o mapa consiste em uma representação bidimensional de um objeto tridimensional.

A questão é simples: para pequenas distâncias, a terra é aproximadamente plana. Isto quer dizer que podemos aproximar uma capa esférica por um plano tangente.

Naturalmente, quanto mais distantes estivermos do ponto x, maior vai ser a distorção entre a representação do plano e o ponto real na esfera. Esta é a velha questão da aproximação do seno pelo seu argumento.

Este tipo de problema é resolvido (parcialmente) com o uso de projeções cartográficas. Existem um grande número de projeções.

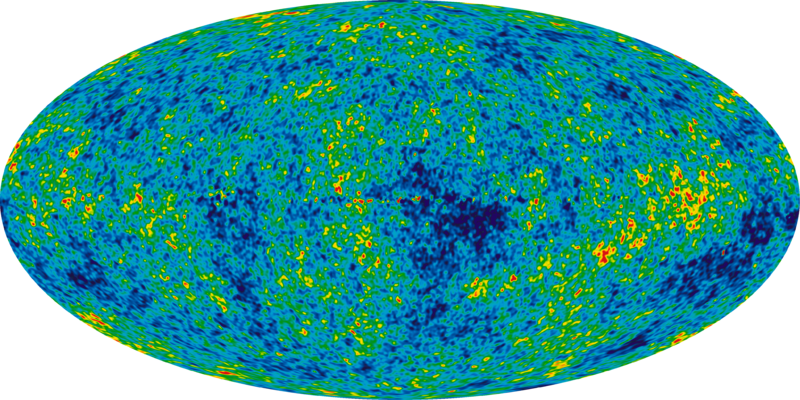

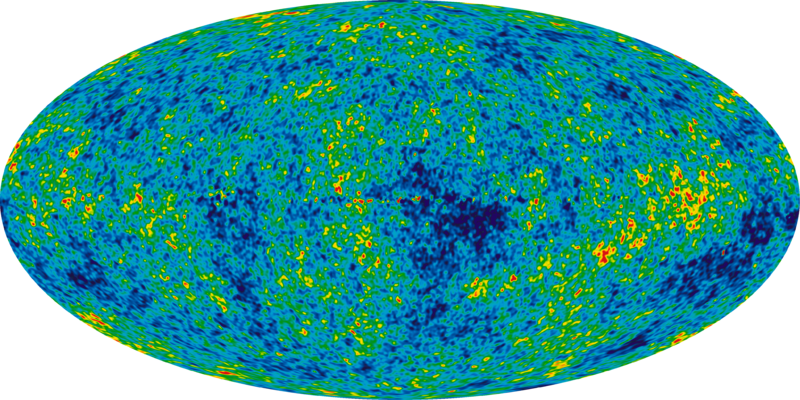

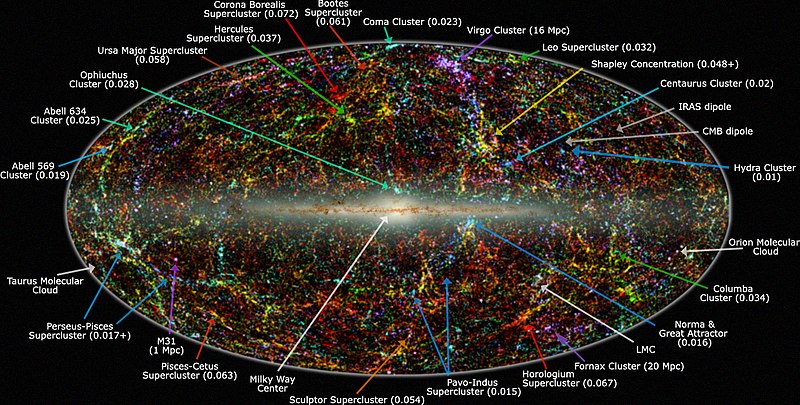

No caso em questão o interesse é da projeção de Mollweide. Esta projeção é muito vista hoje em dia. Seja na representação da radiação de fundo de microondas.

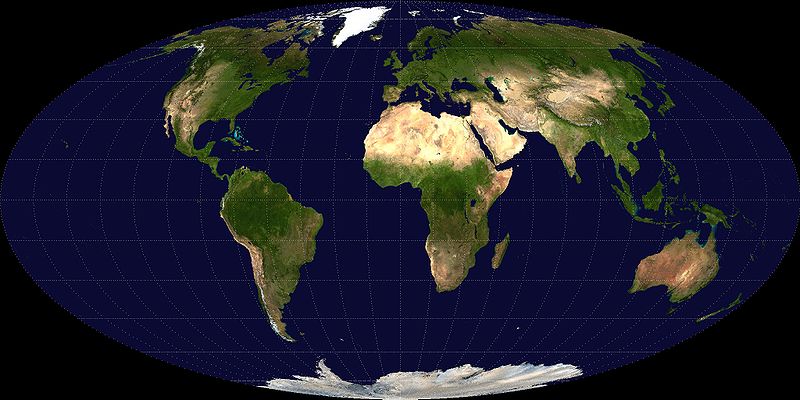

Seja na própria terra

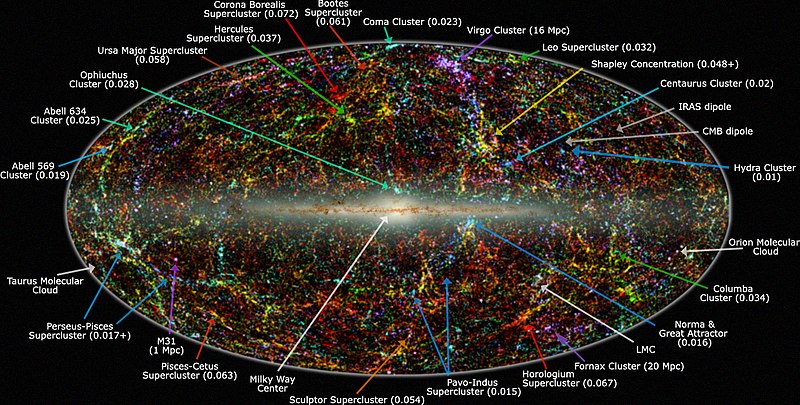

De fato, o ponto deste artigo é que nas representações do céu, o que estamos vendo é o céu olhando do centro de uma esfera. Então temos várias representações do universo:

Em infra-vermelho:

Mas isso tudo fica mais fácil com o instrumento apropriado.

No caso, o mapa consiste em uma representação bidimensional de um objeto tridimensional.

A questão é simples: para pequenas distâncias, a terra é aproximadamente plana. Isto quer dizer que podemos aproximar uma capa esférica por um plano tangente.

Naturalmente, quanto mais distantes estivermos do ponto x, maior vai ser a distorção entre a representação do plano e o ponto real na esfera. Esta é a velha questão da aproximação do seno pelo seu argumento.

Este tipo de problema é resolvido (parcialmente) com o uso de projeções cartográficas. Existem um grande número de projeções.

No caso em questão o interesse é da projeção de Mollweide. Esta projeção é muito vista hoje em dia. Seja na representação da radiação de fundo de microondas.

Seja na própria terra

De fato, o ponto deste artigo é que nas representações do céu, o que estamos vendo é o céu olhando do centro de uma esfera. Então temos várias representações do universo:

Em infra-vermelho:

Mas isso tudo fica mais fácil com o instrumento apropriado.

Um mês de 4 semanas ou de 5 semanas?

Você já deve ter ouvido que um mês tem quatro semanas, certo? Mas isso é verdade mesmo? Bem, para fevereiro é verdade mesmo. Afinal 1 semana tem 7 dias, e 4 vezes 7 dá 28.

E um ano de 52 semanas? Já ouviu falar? Mas é verdade mesmo? Bem, se 1 semana tem 7 dias e o ano tem 52 semanas, então temos 364 dias em um ano.

Então nem todos os meses tem 4 semanas e o ano não tem exatamente 52 semanas. Qual é o problema? O problema é múltiplo: primeiro a terra gira em torno de si mesmo e segundo a terra gira em torno do sol. Cada problema pode ser melhor explicado juntando os dois casos. Como a explicação vai estar em itálico, quem não estiver interessado pode pular até quando volta ao normal.

Um dia solar aparente é definido como o intervalo de tempo entre o retorno do sol ao mesmo meridiano. Como além da terra girar em torno de si mesma, ela também gira em torno do sol. Este intervalo é variável ao longo do ano solar (que é o tempo que a terra leva para retornar ao mesmo ponto na órbita).

A questão é que a terra está inclinada e que a órbita ao redor do sol é uma elipse. Isto faz com que haja uma variação no dia. Em 2010, o dia mais longo teve 86471 segundos e o mais curto 86325 segundos.

Então como definir o dia? Um modo é usar o dia solar médio. Este é de 86400 segundos (mais alguns milisegundos). Como 24 horas correspondem a 86400 segundos então teríamos que o dia solar médio é o nosso dia como conhecemos. Já o dia sideral é outra história (correspondendo a 86164.09053083288 segundos).

Bem qual é a diferença principal entre o dia solar médio e o dia sideral? Bom em 1 dia sideral a terra gira 360 graus, e em um dia solar a terra gira 360.9856 graus.

Bem em termos de segundos, o ano sideral tem 31558149.76 segundos (365.256363004 dias solares). Comparando isto com o número que temos de 31536000 segundos (365 dias x 24/dia x 60 minutos/hora x 60 segundos/minuto), temos que o ano sideral é maior por cerca de 22149.76 segundos.

Por causa do 0.256363004 dias solares é que temos os anos bissextos.

Então um ano tem aproximadamente 365.2564 dias (e não 365 como é normalmente contado). Esta diferença quer dizer dizer que ao longo de 4 anos teremos 1461 dias ao invés de 1460 dias.

Mas para efeitos de cálculo vamos nos ater aos anos de 364 e 365 dias.

Os fatores de 364 são 4, 7 e 13 - podemos montar qualquer arranjo com estes números que satisfariam o que chamamos de ano. Assim:

E um ano de 52 semanas? Já ouviu falar? Mas é verdade mesmo? Bem, se 1 semana tem 7 dias e o ano tem 52 semanas, então temos 364 dias em um ano.

Então nem todos os meses tem 4 semanas e o ano não tem exatamente 52 semanas. Qual é o problema? O problema é múltiplo: primeiro a terra gira em torno de si mesmo e segundo a terra gira em torno do sol. Cada problema pode ser melhor explicado juntando os dois casos. Como a explicação vai estar em itálico, quem não estiver interessado pode pular até quando volta ao normal.

Um dia solar aparente é definido como o intervalo de tempo entre o retorno do sol ao mesmo meridiano. Como além da terra girar em torno de si mesma, ela também gira em torno do sol. Este intervalo é variável ao longo do ano solar (que é o tempo que a terra leva para retornar ao mesmo ponto na órbita).

A questão é que a terra está inclinada e que a órbita ao redor do sol é uma elipse. Isto faz com que haja uma variação no dia. Em 2010, o dia mais longo teve 86471 segundos e o mais curto 86325 segundos.

Então como definir o dia? Um modo é usar o dia solar médio. Este é de 86400 segundos (mais alguns milisegundos). Como 24 horas correspondem a 86400 segundos então teríamos que o dia solar médio é o nosso dia como conhecemos. Já o dia sideral é outra história (correspondendo a 86164.09053083288 segundos).

Bem qual é a diferença principal entre o dia solar médio e o dia sideral? Bom em 1 dia sideral a terra gira 360 graus, e em um dia solar a terra gira 360.9856 graus.

Bem em termos de segundos, o ano sideral tem 31558149.76 segundos (365.256363004 dias solares). Comparando isto com o número que temos de 31536000 segundos (365 dias x 24/dia x 60 minutos/hora x 60 segundos/minuto), temos que o ano sideral é maior por cerca de 22149.76 segundos.

Por causa do 0.256363004 dias solares é que temos os anos bissextos.

Então um ano tem aproximadamente 365.2564 dias (e não 365 como é normalmente contado). Esta diferença quer dizer dizer que ao longo de 4 anos teremos 1461 dias ao invés de 1460 dias.

Mas para efeitos de cálculo vamos nos ater aos anos de 364 e 365 dias.

Os fatores de 364 são 4, 7 e 13 - podemos montar qualquer arranjo com estes números que satisfariam o que chamamos de ano. Assim:

- 4 dias por semana, 7 semanas por mês e 13 meses por ano

- 4 dias por semana, 13 semanas por mês e 4 meses por ano

- 7 dias por semana, 13 semanas por mês e 4 meses por ano

- 7 dias por semana, 4 semanas por mês e 13 meses por ano

- 13 dias por semana, 4 semanas por mês e 7 meses por ano

- 13 dias por semana, 7 semanas por mês e 4 meses por ano

No caso de 365, os fatores são 5 e 73, assim teríamos um ciclo a menos

- 5 dias por semana e 73 semanas por ano

- 73 dias por mês e 5 meses por ano.

Mas o fato é que isto complica mais do que ajuda. Então quais são as alternativas? Poderíamos arbitrar que o ano teria 364 dias e acrescentar mais 5 dias ao final de um conjunto de 4 anos. Alternativamente, podemos alterar a duração dos meses. Com 5 meses de 31 dias e 7 meses de 30 dias teremos 365 dias. E com 6 meses de 31 dias e 6 meses de 30 dias teremos 366.

Acredito que esta forma é até mais agradável, teríamos 3 anos com 5 * 31 + 7 * 30 e 1 ano com 6*31 + 6*30.

Naturalmente com 365 dias não há como dividir o ano em 52 semanas de 7 dias. Poderíamos neste esquema ter o mês de 30 dias com 5 semanas de 6 dias

O importante nesta história é lembrar que o ano tem 365 dias e 1/4, e que 7 dias/semana vezes 4 semanas/mês vezes 12 meses no ano dão 336 dias. Do mesmo jeito 30 dias por mês e 12 meses por ano dão 360 dias.

Em resumo:

Se alguém te falar que existem 7 dias na semana, 4 semanas por mês e 12 meses no ano, você pode perguntar: Isso dá 336, e os 29 dias restantes?

E se alguém te falar que tem 30 dias por mês e 12 meses por ano, você pode perguntar: Isso dá 360, e os 5 dias restantes?

quarta-feira, 16 de fevereiro de 2011

Seguindo o contra-intutivo

Infelizmente as conseqüências de uma análise errada de um problema contra-intuitivo podem ser bem sérias. E costumam ser mais graves quanto maior a confiança no modelo teórico usado para caracterizar o problema.

Em determinados casos, o caso real é não linear, mas pode ser aproximado por um modelo linear. Em outros casos, o caso real é dinâmico mas o modelo é estático. E em outros casos, o modelo simplesmente não funciona sob as condições que são aplicadas (isto é bem comum - um resistor tem limites de dissipação de calor, que não costumam ser incluídos no modelo de circuito).

E nisto tem-se um mundo de problemas criados pela incompreensão de como modelar a realidade sob aquelas circunstâncias.

Você sabia que no caso de tráfego de carros, a adição de mais uma via pode piorar o tráfego?

Sim, é verdade. Mas há outros exemplos: a adição de pessoas para resolução de um problema pode aumentar o tempo de resolução.

Existem diversas dessas "leis" compiladas. Algumas são empíricas, outras são teóricas e outras são anedóticas.

Uma das minhas preferidas é a Lei de Campbell: Em termos simples, quanto mais um indicador quantitativo for utilizado para tomada de decisão social, maior será a pressão para distorcer e corromper o processo social que se desejava monitorar.

Este fenômeno é bem conhecido dos professores, pois está diretamente relacionado com o fenômeno da trapaça acadêmica (e não estou falando apenas dos alunos).

Eu vejo um comportamento assustadoramente consistente com esta Lei no caso da avaliação CAPES.

O que me faz escrever minha própria lei: Um indicador é melhor do que nenhum, mas vários indicadores independentes são bem melhores do que apenas um.

Reparem na palavra "independentes". Ela não está ali por acaso.

O que me leva a questão central deste post: será que atender todas as demandas de uma organização sempre se traduz em ganhos de produtividade?

Suspeito que não...

Em determinados casos, o caso real é não linear, mas pode ser aproximado por um modelo linear. Em outros casos, o caso real é dinâmico mas o modelo é estático. E em outros casos, o modelo simplesmente não funciona sob as condições que são aplicadas (isto é bem comum - um resistor tem limites de dissipação de calor, que não costumam ser incluídos no modelo de circuito).

E nisto tem-se um mundo de problemas criados pela incompreensão de como modelar a realidade sob aquelas circunstâncias.

Você sabia que no caso de tráfego de carros, a adição de mais uma via pode piorar o tráfego?

Sim, é verdade. Mas há outros exemplos: a adição de pessoas para resolução de um problema pode aumentar o tempo de resolução.

Existem diversas dessas "leis" compiladas. Algumas são empíricas, outras são teóricas e outras são anedóticas.

Uma das minhas preferidas é a Lei de Campbell: Em termos simples, quanto mais um indicador quantitativo for utilizado para tomada de decisão social, maior será a pressão para distorcer e corromper o processo social que se desejava monitorar.

Este fenômeno é bem conhecido dos professores, pois está diretamente relacionado com o fenômeno da trapaça acadêmica (e não estou falando apenas dos alunos).

Eu vejo um comportamento assustadoramente consistente com esta Lei no caso da avaliação CAPES.

O que me faz escrever minha própria lei: Um indicador é melhor do que nenhum, mas vários indicadores independentes são bem melhores do que apenas um.

Reparem na palavra "independentes". Ela não está ali por acaso.

O que me leva a questão central deste post: será que atender todas as demandas de uma organização sempre se traduz em ganhos de produtividade?

Suspeito que não...

Contra-Intuitvo

Você já esteve em uma situação que sua intuição dizia que iria acontecer uma coisa, mas aconteceu precisamente o contrário?

Estas situações representam o que chama-se de contra-intuitivo. A verdade é que nosso modelo mental do mundo falha miseravelmente nestas situações. Chamamos as vezes destas situações de paradoxos (apesar de tecnicamente não constituirem paradoxos propriamente ditos).

Quer ver alguns que são conclusões intuitivas totalmente erradas? Que a terra é plana, que o sol gira ao redor da terra, que água fria congela mais rápido que água quente.

Sim, tudo isso é intuitivo - e errado! Existem listas e mais listas de paradoxos. O que se percebe é que há limites para nossa confiança na intuição.

Suspeito que é nos paradoxos que compreendemos melhor os limites do nosso conhecimento. Ao se resolver o paradoxo ganha-se conhecimento sobre o problema em questão. Mais interessante é que parte das questões que formulamos são na realidade uma forma de expressar um paradoxo no modelo mental do tópico.

Então formular paradoxos não é somente divertido, mas educativo. Talvez mais educativo do que resolver paradoxos.

Um ponto curioso é que quando o paradoxo é resolvido, ou quando a intuição é transformada, costumamos esquecer de quão grande foi o salto intelectual para se vencer este problema.

Não deixa de ser um paradoxo

Estas situações representam o que chama-se de contra-intuitivo. A verdade é que nosso modelo mental do mundo falha miseravelmente nestas situações. Chamamos as vezes destas situações de paradoxos (apesar de tecnicamente não constituirem paradoxos propriamente ditos).

Quer ver alguns que são conclusões intuitivas totalmente erradas? Que a terra é plana, que o sol gira ao redor da terra, que água fria congela mais rápido que água quente.

Sim, tudo isso é intuitivo - e errado! Existem listas e mais listas de paradoxos. O que se percebe é que há limites para nossa confiança na intuição.

Suspeito que é nos paradoxos que compreendemos melhor os limites do nosso conhecimento. Ao se resolver o paradoxo ganha-se conhecimento sobre o problema em questão. Mais interessante é que parte das questões que formulamos são na realidade uma forma de expressar um paradoxo no modelo mental do tópico.

Então formular paradoxos não é somente divertido, mas educativo. Talvez mais educativo do que resolver paradoxos.

Um ponto curioso é que quando o paradoxo é resolvido, ou quando a intuição é transformada, costumamos esquecer de quão grande foi o salto intelectual para se vencer este problema.

Não deixa de ser um paradoxo

terça-feira, 15 de fevereiro de 2011

Demanda de Vagas na Engenharia Elétrica

Um debate animado (mas nem tanto) tem corrido pelo departamento de engenharia elétrica da UnB. O ponto central do debate é justamente a queda dos argumentos de um dos cursos.

No entanto, o máximo argumento e o mínimo argumento não contam bem a história. No caso do máximo argumento isto é bem claro porque o mesmo só representa o desempenho do candidato aprovado com a melhor prova. Poderíamos associar o argumento máximo com a atratividade do curso - um argumento consistentemente alto significa que o curso costuma atrair bons alunos. Já com o argumento mínimo, a situação não é tão clara. Naturalmente, este argumento indica que o desempenho do candidato aprovado com a pior prova.

Enquanto a melhor prova não diz muito, a pior prova diz um bocado. De fato, um argumento mínimo muito ruim indica que o mínimo para passar foi, bem, na falta de uma palavra melhor, ruim...

No entanto, somente o conhecimento da distribuição pode indicar realmente mais clareza sobre o assunto.

Mas existe um relacionamento entre os argumentos e a procura do curso. Isto sugere que uma procura maior tende a resultar em argumentos maiores (o que nem sempre é o caso, mas é uma aproximação razoável).

Bem, vamos aos dados. No curso de engenharia elétrica, do 1-2004 ao 1-2009, o número de candidatos variou entre 255 até 331 candidatos. Já a partir do 2-2009, este número caiu para 188-213 candidatos. Em termos da média 294.5 para 199.75 (uma queda de quase 100 candidatos). Em termos de desvio padrão, tivemos uma baixa de 30 para 10.2.

Isto indica uma queda na procura do curso de engenharia elétrica pelos candidatos. E os argumentos? Bem aí temos de ver o caso do sistema universal, o das cotas e o PAS. E para piorar, nem todos os anos estão disponíveis. Mas para simplificar, vamos ficar no sistema universal.

No entanto, o máximo argumento e o mínimo argumento não contam bem a história. No caso do máximo argumento isto é bem claro porque o mesmo só representa o desempenho do candidato aprovado com a melhor prova. Poderíamos associar o argumento máximo com a atratividade do curso - um argumento consistentemente alto significa que o curso costuma atrair bons alunos. Já com o argumento mínimo, a situação não é tão clara. Naturalmente, este argumento indica que o desempenho do candidato aprovado com a pior prova.

Enquanto a melhor prova não diz muito, a pior prova diz um bocado. De fato, um argumento mínimo muito ruim indica que o mínimo para passar foi, bem, na falta de uma palavra melhor, ruim...

No entanto, somente o conhecimento da distribuição pode indicar realmente mais clareza sobre o assunto.

Mas existe um relacionamento entre os argumentos e a procura do curso. Isto sugere que uma procura maior tende a resultar em argumentos maiores (o que nem sempre é o caso, mas é uma aproximação razoável).

Bem, vamos aos dados. No curso de engenharia elétrica, do 1-2004 ao 1-2009, o número de candidatos variou entre 255 até 331 candidatos. Já a partir do 2-2009, este número caiu para 188-213 candidatos. Em termos da média 294.5 para 199.75 (uma queda de quase 100 candidatos). Em termos de desvio padrão, tivemos uma baixa de 30 para 10.2.

Isto indica uma queda na procura do curso de engenharia elétrica pelos candidatos. E os argumentos? Bem aí temos de ver o caso do sistema universal, o das cotas e o PAS. E para piorar, nem todos os anos estão disponíveis. Mas para simplificar, vamos ficar no sistema universal.

- antes de 1-2009, o menor argumento mínimo foi 174.6 (em 2-2007), o maior foi de 236.5 (em 1-2009).

- depois de 1-2009, o menor argumento mínimo foi de 136.3 (em 2-2010) e o maior foi 268.5 (em 1-2011).

- antes de 1-2009, o menor argumento máximo foi 308.9 (em 2-2008), o maior foi de 409.8 (em 2-2006).

- depois de 1-2009, o menor argumento máximo foi de 322.6 (em 2-2009) e o maior foi 366.6 (em 2-2010).

Com esses dados não é possível afirmar que houve uma diminuição na atratividade ou na qualidade dos candidatos.

Vamos ao caso de engenharia de redes. O número de candidatos vem caindo bem antes de 2009. Se fizermos a média de candidatos antes de 1-2009 temos 255.2 candidatos com um desvio de 24.7. Já depois de 1-2009 temos uma média de 162.6 com desvio de 22.8. Um desvio tão alto assim parece indicar uma queda da procura média com o tempo.

Em temos dos argumentos temos:

- antes de 1-2009, o menor argumento mínimo foi 143.1 (em 2-2006), o maior foi 201.6 (em 2-2004). Com relação ao argumento máximo, o menor foi 286 (em 2-2006), o maior foi 365.2 (em 2-2007)

- depois de 1-2009, o menor argumento mínimo foi 7.7 (em 2-2010), o maior foi 201.9 (em 1-2009). Com relação ao argumento máximo, o menor foi 214.1 (em 2-2010), o maior foi 270.9 (em 1-2009)

Neste caso, parece mesmo que tivemos uma queda na qualidade dos candidatos e também uma queda na atratividade do curso.

segunda-feira, 14 de fevereiro de 2011

Um pouco mais sobre taxa de ocupação

Como visto no post anterior, um sistema similar ao telefônico descreve picos de ocupação temporal que equivalem a uma curva módulo de seno. E devido a esta característica temporal, a taxa de ocupação média não será particularmente elevada.

Esta questão tem muito do problema da forma do tráfego envolvido. Há um pico e o mesmo tende a diminuir bastante com o tempo. Tipicamente, o pico é no meio do dia e o vale na parte da noite/ madrugada

Isto sugere que o canal poderia ser melhor aproveitado por um sistema que tivesse características inversas do tipo de tráfego encontrado, ou seja maior na parte da noite/madrugada tendendo a ter o vale na parte do dia.

Ou seja, se um dos tráfegos é do tipo seno, o outro seria do tipo cosseno. Neste caso a eficiência do uso sobe de 63.7% para 90%. Mas há a necessidade para que os dois tipos de tráfego passem a ter o pico de 70.7% do valor máximo.

De modo prático, isto significa reduzir o tráfego máximo suportado em uma hora de pico de modo a aumentar o tráfego médio em outros horários.

Parece paradoxal, mas não é.

Possivelmente, aumentando a diversidade de serviços com diferentes perfis de tráfego seja possível melhorar substancialmente a ocupação média do canal - e portanto a taxa de ocupação

Esta questão tem muito do problema da forma do tráfego envolvido. Há um pico e o mesmo tende a diminuir bastante com o tempo. Tipicamente, o pico é no meio do dia e o vale na parte da noite/ madrugada

Isto sugere que o canal poderia ser melhor aproveitado por um sistema que tivesse características inversas do tipo de tráfego encontrado, ou seja maior na parte da noite/madrugada tendendo a ter o vale na parte do dia.

Ou seja, se um dos tráfegos é do tipo seno, o outro seria do tipo cosseno. Neste caso a eficiência do uso sobe de 63.7% para 90%. Mas há a necessidade para que os dois tipos de tráfego passem a ter o pico de 70.7% do valor máximo.

De modo prático, isto significa reduzir o tráfego máximo suportado em uma hora de pico de modo a aumentar o tráfego médio em outros horários.

Parece paradoxal, mas não é.

Possivelmente, aumentando a diversidade de serviços com diferentes perfis de tráfego seja possível melhorar substancialmente a ocupação média do canal - e portanto a taxa de ocupação

quinta-feira, 10 de fevereiro de 2011

Mais sobre a taxa de ocupação

Após o estudo inicial sobre taxa de ocupação, voltei meus olhos para questão da ocupação de um canal telefônico. Para descobrir a taxa de ocupação é necessário quantificar o uso. E isto recai no estudo do tráfego.

O tráfego pode ser aproximado por uma função módulo de seno. Isto quer dizer que a mesma se repete a cada período (que é o dobro do período normal). Podemos definir a transformada desta função para 1 dia e verificar como a mesma se comporta com relação a este período.

Isto significa apenas a transformada seno com os limites de zero a Pi. O problema desta forma é que podemos fazer isto com relação ao dia, mas não temos informações em escalas maiores. Mas o conceito realmente funciona.

De qualquer modo, a lição importante é que o sistema não opera na capacidade máxima. Como existe variação ao longo do dia na carga do sistema, o mesmo fica longe de operar no máximo de sua eficiência. Pela manhã o tráfego é menor, crescendo até o meio do dia e diminuindo com o passar do tempo.

Neste caso é necessário calcular a distribuição de probabilidade. Se dividirmos a função em três partes em termos da eficiência (0 a Pi/4, Pi/4 a 3*Pi/4 e de 3*Pi/4 a Pi). Teremos dois pontos de eficiência:

- Eficiência de 0.1913 com probabilidade 0.293

- Eficiência de 1 com probabilidade 0.462

Se dividirmos em mais pontos (0 a Pi/6, Pi/6 a 2*Pi/6, 2*Pi/6 a 3*Pi/6 e o resto é simétrico) teremos:

- Eficiência de 0.129 com probabilidade de 0.134

- Eficiência de 0.354 com probabilidade de 0.366

- Eficiência de 0.483 com probabilidade de 0.5

Daí vemos que a eficiência é na vizinhança de 0.38 - 0.39.

Isto pode ser verificado com maior acurácia através do cálculo da distribuição de probabilidade associada a curva. Mas ainda preciso descobrir como achar esta curva de modo analítico.

O tráfego pode ser aproximado por uma função módulo de seno. Isto quer dizer que a mesma se repete a cada período (que é o dobro do período normal). Podemos definir a transformada desta função para 1 dia e verificar como a mesma se comporta com relação a este período.

Isto significa apenas a transformada seno com os limites de zero a Pi. O problema desta forma é que podemos fazer isto com relação ao dia, mas não temos informações em escalas maiores. Mas o conceito realmente funciona.

De qualquer modo, a lição importante é que o sistema não opera na capacidade máxima. Como existe variação ao longo do dia na carga do sistema, o mesmo fica longe de operar no máximo de sua eficiência. Pela manhã o tráfego é menor, crescendo até o meio do dia e diminuindo com o passar do tempo.

Neste caso é necessário calcular a distribuição de probabilidade. Se dividirmos a função em três partes em termos da eficiência (0 a Pi/4, Pi/4 a 3*Pi/4 e de 3*Pi/4 a Pi). Teremos dois pontos de eficiência:

- Eficiência de 0.1913 com probabilidade 0.293

- Eficiência de 1 com probabilidade 0.462

Se dividirmos em mais pontos (0 a Pi/6, Pi/6 a 2*Pi/6, 2*Pi/6 a 3*Pi/6 e o resto é simétrico) teremos:

- Eficiência de 0.129 com probabilidade de 0.134

- Eficiência de 0.354 com probabilidade de 0.366

- Eficiência de 0.483 com probabilidade de 0.5

Daí vemos que a eficiência é na vizinhança de 0.38 - 0.39.

Isto pode ser verificado com maior acurácia através do cálculo da distribuição de probabilidade associada a curva. Mas ainda preciso descobrir como achar esta curva de modo analítico.

quarta-feira, 9 de fevereiro de 2011

Sobre taxa de ocupação

Hoje tive a visita de diversos engenheiros e ex-alunos que hoje estão na Anatel. Vieram com uma proposta interessante que me fez pensar a respeito de um problema: como se define a taxa de ocupação de um canal?

Bem a princípio é simples: como qualquer exemplo seria tempo_ocupado/tempo_medido. Assim, se em um período de 24 horas temos 24 horas de ocupação do canal então a taxa é 1 (ou 100%).

Mas raramente este é o caso. A ocupação do canal é um fenômeno estatístico que efetivamente deve possuir uma distribuição de probabilidade de ocupação. Quanto mais eficiente for esta ocupação, mais próxima de um impulso próximo a 1 esta ocupação será.

Como a distribuição tem limites fixos (taxa de ocupação tem de estar entre 0 e 1) então temos que várias candidatas para possíveis distribuições (beta, logit, u-quadrática, kumaraswamy, e outras). O fato é que haverá momentos superiores associados.

Considerando o espectro como um todo teremos varias fatias dele, algumas estarão ocupadas, outras não. Algumas destas ocupadas terão alta eficiência e outras não. Partindo destas premissas eu diria que a distribuição teria como valor médio o valor médio da ocupação e não seria necessariamente simétrica no seu eixo. A priori, diria até que o terceiro momento seria uma boa medida da eficiência do sistema.

Só que este terceiro momento teria de ser medido em relação ao centro da escala de ocupação do canal. Um problema com esta idéia é que o impulso tem o terceiro momento indefinido.

Este problema só não ocorrerá porque na realidade não teremos eficiência máxima ou mínima em todo o espectro. Mas ainda há uma questão: como definir a eficiência de ocupação em termos do espectro total. A priori é melhor considerar que a eficiência total é a média das eficiência de cada porção do espectro ocupada.

Então se cada eficiência é uma variável aleatória com uma determinada distribuição, a eficiência total será calculada pela soma destas variáveis, o que irá gerar uma nova distribuição. Há uma enorme tentação de se supor que a distribuição final será normal (ou algo truncada), mas não são satisfeitas as condições que impõem o teorema do limite central (as distribuições não são iguais e não pode-se afirmar que haja ou não independência entre elas).

Um modo de se fazer isto é fazendo a convolução entre as distribuições ou usando o produto de funções características.

Acho que vale a pena fazer isto no caso de duas distribuições triangulares com médias (e formatos) diferentes. Neste caso é fazer a média das duas e ver o que vai dar...

Vou fazer a análise disto em um post futuro.

Bem a princípio é simples: como qualquer exemplo seria tempo_ocupado/tempo_medido. Assim, se em um período de 24 horas temos 24 horas de ocupação do canal então a taxa é 1 (ou 100%).

Mas raramente este é o caso. A ocupação do canal é um fenômeno estatístico que efetivamente deve possuir uma distribuição de probabilidade de ocupação. Quanto mais eficiente for esta ocupação, mais próxima de um impulso próximo a 1 esta ocupação será.

Como a distribuição tem limites fixos (taxa de ocupação tem de estar entre 0 e 1) então temos que várias candidatas para possíveis distribuições (beta, logit, u-quadrática, kumaraswamy, e outras). O fato é que haverá momentos superiores associados.

Considerando o espectro como um todo teremos varias fatias dele, algumas estarão ocupadas, outras não. Algumas destas ocupadas terão alta eficiência e outras não. Partindo destas premissas eu diria que a distribuição teria como valor médio o valor médio da ocupação e não seria necessariamente simétrica no seu eixo. A priori, diria até que o terceiro momento seria uma boa medida da eficiência do sistema.

Só que este terceiro momento teria de ser medido em relação ao centro da escala de ocupação do canal. Um problema com esta idéia é que o impulso tem o terceiro momento indefinido.

Este problema só não ocorrerá porque na realidade não teremos eficiência máxima ou mínima em todo o espectro. Mas ainda há uma questão: como definir a eficiência de ocupação em termos do espectro total. A priori é melhor considerar que a eficiência total é a média das eficiência de cada porção do espectro ocupada.

Então se cada eficiência é uma variável aleatória com uma determinada distribuição, a eficiência total será calculada pela soma destas variáveis, o que irá gerar uma nova distribuição. Há uma enorme tentação de se supor que a distribuição final será normal (ou algo truncada), mas não são satisfeitas as condições que impõem o teorema do limite central (as distribuições não são iguais e não pode-se afirmar que haja ou não independência entre elas).

Um modo de se fazer isto é fazendo a convolução entre as distribuições ou usando o produto de funções características.

Acho que vale a pena fazer isto no caso de duas distribuições triangulares com médias (e formatos) diferentes. Neste caso é fazer a média das duas e ver o que vai dar...

Vou fazer a análise disto em um post futuro.

terça-feira, 8 de fevereiro de 2011

Como é ter energia eólica?

Imaginem que você contrate uma pessoa para ficar jogando três dados a cada 30 minutos. Se um lançamento do dado der 1 e os outros dois derem um valor par ele desliga o seu disjuntor geral por 30 minutos.

Por que? Porque o vento é uma variável aleatória. E a distribuição de Probabilidade é do tipo Weibull.

Isso é apenas parte da convivência. Mesmo que não seja zero, a velocidade pode não ser suficiente para suprir a energia necessária. E isto ainda pode ser cíclico.

Claro que existem soluções. Mas a coisa não é nem de longe tão trivial quanto parece

Por que? Porque o vento é uma variável aleatória. E a distribuição de Probabilidade é do tipo Weibull.

Isso é apenas parte da convivência. Mesmo que não seja zero, a velocidade pode não ser suficiente para suprir a energia necessária. E isto ainda pode ser cíclico.

Claro que existem soluções. Mas a coisa não é nem de longe tão trivial quanto parece

Quanto de energia o Brasil precisa?

Na esteira das confusões de Belo Monte, vamos esclarecer o tamanho do problema energético que o Brasil tem de enfrentar.

Em 2010, o Brasil tinha cerca de 112 Gigawatts (GW) instalados. Estima-se que para 2019, precisaremos de 189 GW. Então teremos de adicionar 77 GW nos próximos 9 anos (8 se contarmos com 2011).

Isto significa 8.6 GW por ano aproximadamente. Por que tanto? Existe uma correlação entre o crescimento da oferta de energia e a variação do PIB. Efetivamente, este número muda mas estima-se que cada 2% de aumento na matriz energética corresponda a 1% de aumento no PIB.

Naturalmente, não é simplesmente aumentando a disponibilidade de energia que aumenta-se o PIB. Existem variáveis ocultas (uma delas é justamente o custo da energia e seu uso)..

O fato é que estes 68.75% de aumento na matriz energética implicariam em um aumento do PIB de 34.4% ao longo de 9 anos (aproximadamente um crescimento de 3.5% ao ano).

Muito bem, mas não podemos resolver esta questão do crescimento somente com fontes alternativas? A resposta curta e grossa é não. Podemos resolver parte do problema, mas não todo o problema em si.

A questão das fontes alternativas é precisamente intrínseca a natureza delas. Para funcionamento confiável das mesmas é necessário algum tipo de armazenamento de energia. E aí a coisa complica, pois armazenamento é complicado, caro e, pior de tudo, via de regra poluente. Um dos que não é bem assim é justamente o hídrico (ironia das ironias).

E então vem o dilema? Como resolver a situação? Bem, no fundo temos algumas alternativas - mas todas envolvem em algum ponto a construção de hidroelétricas.

Claro que sempre há a possibilidade do uso de usinas nucleares...

Em 2010, o Brasil tinha cerca de 112 Gigawatts (GW) instalados. Estima-se que para 2019, precisaremos de 189 GW. Então teremos de adicionar 77 GW nos próximos 9 anos (8 se contarmos com 2011).

Isto significa 8.6 GW por ano aproximadamente. Por que tanto? Existe uma correlação entre o crescimento da oferta de energia e a variação do PIB. Efetivamente, este número muda mas estima-se que cada 2% de aumento na matriz energética corresponda a 1% de aumento no PIB.

Naturalmente, não é simplesmente aumentando a disponibilidade de energia que aumenta-se o PIB. Existem variáveis ocultas (uma delas é justamente o custo da energia e seu uso)..

O fato é que estes 68.75% de aumento na matriz energética implicariam em um aumento do PIB de 34.4% ao longo de 9 anos (aproximadamente um crescimento de 3.5% ao ano).

Muito bem, mas não podemos resolver esta questão do crescimento somente com fontes alternativas? A resposta curta e grossa é não. Podemos resolver parte do problema, mas não todo o problema em si.

A questão das fontes alternativas é precisamente intrínseca a natureza delas. Para funcionamento confiável das mesmas é necessário algum tipo de armazenamento de energia. E aí a coisa complica, pois armazenamento é complicado, caro e, pior de tudo, via de regra poluente. Um dos que não é bem assim é justamente o hídrico (ironia das ironias).

E então vem o dilema? Como resolver a situação? Bem, no fundo temos algumas alternativas - mas todas envolvem em algum ponto a construção de hidroelétricas.

Claro que sempre há a possibilidade do uso de usinas nucleares...

domingo, 6 de fevereiro de 2011

Bombeiros causam incêndios?

Bizarro como seja este é o cerne lógico de muitos argumentos. O FMI veio roubar o país, o dívida pública não se paga. A lista é enorme...

E todos eles sofrem do mesmo problema: correlação não é causalidade.

Pode parecer tolo, mas este tipo de erro é muito comum. Em geral, o raciocínio "esquece" uma variável oculta que comanda a ligação entre os dois elementos. Um exemplo é a correlação entre vendas de sorvete e afogamentos em piscinas. Não é que o aumento vendas de sorvete cause aumento nos afogamentos, mas que com o aumento do calor, aumentam as vendas do sorvete e aumentam os afogamentos.

Percebem a variável oculta? O aumento da temperatura!

No caso do FMI, a coisa é mais interessante ainda: quando é que o FMI é necessário? Ora quando o país precisa de dinheiro. O que acontece se o país não pagar? Ninguém mais empresta dinheiro.

No caso da dívida pública: o que é dívida pública, para começo de conversa. E quem são os credores? Ah, essa é ótima: praticamente todo mundo, pessoas físicas e jurídicas (e não apenas grandes especuladores como falam). O que acontece se der calote? o país trava! E ninguém mesmo empresta mais dinheiro ao país.

O FMI vem ao país porque o país precisa de dinheiro de modo urgente. Ninguém vem emprestar dinheiro a alguém que se recusa a receber dinheiro. A dívida pública decorre da necessidade de financiamento do país.

E por fim: bombeiro aparece para pagar incêndio e não para cria-los

E todos eles sofrem do mesmo problema: correlação não é causalidade.

Pode parecer tolo, mas este tipo de erro é muito comum. Em geral, o raciocínio "esquece" uma variável oculta que comanda a ligação entre os dois elementos. Um exemplo é a correlação entre vendas de sorvete e afogamentos em piscinas. Não é que o aumento vendas de sorvete cause aumento nos afogamentos, mas que com o aumento do calor, aumentam as vendas do sorvete e aumentam os afogamentos.

Percebem a variável oculta? O aumento da temperatura!

No caso do FMI, a coisa é mais interessante ainda: quando é que o FMI é necessário? Ora quando o país precisa de dinheiro. O que acontece se o país não pagar? Ninguém mais empresta dinheiro.

No caso da dívida pública: o que é dívida pública, para começo de conversa. E quem são os credores? Ah, essa é ótima: praticamente todo mundo, pessoas físicas e jurídicas (e não apenas grandes especuladores como falam). O que acontece se der calote? o país trava! E ninguém mesmo empresta mais dinheiro ao país.

O FMI vem ao país porque o país precisa de dinheiro de modo urgente. Ninguém vem emprestar dinheiro a alguém que se recusa a receber dinheiro. A dívida pública decorre da necessidade de financiamento do país.

E por fim: bombeiro aparece para pagar incêndio e não para cria-los

quinta-feira, 3 de fevereiro de 2011

Um quilo de chumbo e um quilo de algodão tem pesos diferentes?

Há uma pegadinha famosa em física: o que pesa mais? Um quilo de chumbo ou um quilo de algodão?

Aí tem uma coisa raramente percebida, esta pergunta é diferente de: o que tem mais massa? Um quilo de chumbo ou um quilo de algodão?

A diferença é sutil. Se estamos falando de um problema no vácuo, a resposta é igual nos dois. Mas se estamos falando na atmosfera terrestre, as duas perguntas tem respostas diferentes.

Como?

A resposta é que a atmosfera é um fluido. E como é um fluido temos empuxo! O que o empuxo irá fazer será "diminuir" o valor por causa que um quilo de algodão tem mais volume que um quilo de chumbo.

Portanto há uma força que surge pelo fato dos dois materiais estarem imersos no ar. Esta força é dada por:

Aonde Vf é a volume do material, rho_f é a densidade do fluido e g é aceleração da gravidade. Considerando a diferença da medição entre os pesos temos a seguinte equação:

m*g*(rho_fluido/rho_chumbo - rho_fluido/rho_algodão)

Se não houver fluido então rho_fluido = 0 e os pesos são iguais. Mas na nossa atmosfera, a 25 graus, rho_fluido é 1.184. O rho_algodão é 230 kg/m3 e rho_chumbo é 11340 kg/m3

Então qual é a diferença? 0.005 N.

Em termos práticos 1 kg de algodão corresponde à 995 gramas de chumbo. Se eu colocar um quilo de algodão em uma balança, eu consigo equilibrar isso com 995 gramas de chumbo.

Ou seja: O peso de 1 kg de algodão na atmosfera é menor que um 1 kg de chumbo.

Pegadinhas são fogo

Aí tem uma coisa raramente percebida, esta pergunta é diferente de: o que tem mais massa? Um quilo de chumbo ou um quilo de algodão?

A diferença é sutil. Se estamos falando de um problema no vácuo, a resposta é igual nos dois. Mas se estamos falando na atmosfera terrestre, as duas perguntas tem respostas diferentes.

Como?

A resposta é que a atmosfera é um fluido. E como é um fluido temos empuxo! O que o empuxo irá fazer será "diminuir" o valor por causa que um quilo de algodão tem mais volume que um quilo de chumbo.

Portanto há uma força que surge pelo fato dos dois materiais estarem imersos no ar. Esta força é dada por:

Aonde Vf é a volume do material, rho_f é a densidade do fluido e g é aceleração da gravidade. Considerando a diferença da medição entre os pesos temos a seguinte equação:

m*g*(rho_fluido/rho_chumbo - rho_fluido/rho_algodão)

Se não houver fluido então rho_fluido = 0 e os pesos são iguais. Mas na nossa atmosfera, a 25 graus, rho_fluido é 1.184. O rho_algodão é 230 kg/m3 e rho_chumbo é 11340 kg/m3

Então qual é a diferença? 0.005 N.

Em termos práticos 1 kg de algodão corresponde à 995 gramas de chumbo. Se eu colocar um quilo de algodão em uma balança, eu consigo equilibrar isso com 995 gramas de chumbo.

Ou seja: O peso de 1 kg de algodão na atmosfera é menor que um 1 kg de chumbo.

Pegadinhas são fogo

Suposições, Causalidade e Realidade

Um problema que sempre me incomoda em Teorias da Conspiração é a necessidade de precognição para que o arcabouço "lógico" da teoria funcione.

Um exemplo: uma pessoa realiza uma ação que não faz muito sentido no presente considerando que esta ação irá render dividendos no futuro (a Mais Valia sendo o exemplo mais bobo de todos). Outro exemplo: um planejamento complicado cujos os ganhos futuros baseiam-se em uma seqüência de eventos ocorrerem de modo correto (a conspiração do 11 de setembro sendo o exemplo mais comum).

O problema todo é a questão da causalidade. Assim como nós não temos capacidade de antecipar o futuro com clareza, os nosso antepassados sofriam da mesma condição. Claro que podemos tentar planejar... Mas como todo planejamento é impossível levar em consideração o imprevisível.

Pode-se argumentar que o imprevisível é raro. Bem, isto é muito difícil de afirmar com certeza pois não se pode ter certeza exatamente de quão raro ele realmente é ou quão previsível ele poderia ser a priori.

Racionalmente pode-se listar cursos de ações mais prováveis e planejar de acordo. O problema é a suposição de ação racional. Ela costuma furar terrivelmente. Vamos a um exemplo: ontem manifestantes ocuparam o prédio do ministério do trabalho. O motivo?

Os manifestantes pediam aumento real de 62% no salário mínimo, revogação do aumento dos parlamentares, além da destinação fixa de 10% do PIB para a educação.

Bom, naturalmente o ministro não tem absolutamente o menor poder de realizar estas reivindicações. Não há justificativa lógica para este curso de ação.

No entanto ele ocorreu, e tinha sido decidido há mais de um mês.

Então como isso pode ser antecipado? Bem, por uma análise de possíveis desdobramentos é virtualmente impossível. Só passa a ser possível se alguém estiver informado de qual o curso de ação planejado. E aí chegamos ao ponto: Tem que combinar com os russos. E aí que todo o edifício "teórico" de causa e efeito desaba.

E o que sobra? A dura realidade com suas incertezas - que podem ser simplesmente fruto do desconhecimento de todos os meandros do problema.

Um exemplo: uma pessoa realiza uma ação que não faz muito sentido no presente considerando que esta ação irá render dividendos no futuro (a Mais Valia sendo o exemplo mais bobo de todos). Outro exemplo: um planejamento complicado cujos os ganhos futuros baseiam-se em uma seqüência de eventos ocorrerem de modo correto (a conspiração do 11 de setembro sendo o exemplo mais comum).

O problema todo é a questão da causalidade. Assim como nós não temos capacidade de antecipar o futuro com clareza, os nosso antepassados sofriam da mesma condição. Claro que podemos tentar planejar... Mas como todo planejamento é impossível levar em consideração o imprevisível.

Pode-se argumentar que o imprevisível é raro. Bem, isto é muito difícil de afirmar com certeza pois não se pode ter certeza exatamente de quão raro ele realmente é ou quão previsível ele poderia ser a priori.

Racionalmente pode-se listar cursos de ações mais prováveis e planejar de acordo. O problema é a suposição de ação racional. Ela costuma furar terrivelmente. Vamos a um exemplo: ontem manifestantes ocuparam o prédio do ministério do trabalho. O motivo?

Os manifestantes pediam aumento real de 62% no salário mínimo, revogação do aumento dos parlamentares, além da destinação fixa de 10% do PIB para a educação.

Bom, naturalmente o ministro não tem absolutamente o menor poder de realizar estas reivindicações. Não há justificativa lógica para este curso de ação.

No entanto ele ocorreu, e tinha sido decidido há mais de um mês.

Então como isso pode ser antecipado? Bem, por uma análise de possíveis desdobramentos é virtualmente impossível. Só passa a ser possível se alguém estiver informado de qual o curso de ação planejado. E aí chegamos ao ponto: Tem que combinar com os russos. E aí que todo o edifício "teórico" de causa e efeito desaba.

E o que sobra? A dura realidade com suas incertezas - que podem ser simplesmente fruto do desconhecimento de todos os meandros do problema.

quarta-feira, 2 de fevereiro de 2011

Causalidade,Suposições e Realidade

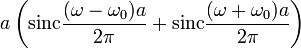

Uma ferramenta matemática muito interessante é a transformada de Fourier. Podemos ver uma transformada como uma técnica de mudança de domínio de um problema. O exemplo clássico é quando mudamos do domínio do tempo para o domínio da freqüência.

Há algumas coisas curiosas sobre a transformada de Fourier e freqüências puras. Pela transformada é possível verificar que só é possível obter um sinal de frequência pura (tom único). Em termos práticos, um sinal:

Terá a transformada uma soma de deltas de Dirac:

Mas um sinal que comece a partir de t=0 e não termine nunca.

terá uma transformada com os deltas e mais um conteúdo espectral adicional.

Mas esta não é a coisa extraordinária. O extraordinário é que um sinal que comece em em um certo t0 e termine em algum tempo no futuro:

Aonde rect á função porta. Terá a transformada:

Então vem a dúvida óbvia: como a transformada "sabe" que o sinal começou em t=0 e se desliga em algum tempo futuro? A resposta é clara na definição da transformada: ela abrange todo o passado e todo o futuro.

Então por isso poderia se pensar que a transformada não tem aplicações práticas. Bem, isto é um equívoco. A transformada em si teria várias limitações nas aplicações práticas, mas uma variante desta (a transformada rápida de Fourier) tem múltiplos usos.

No fundo há pouco interesse em se é uma ou outra utilizada, já que via de regra os resultados são similares.

Mas é a filosofia da coisa que é realmente interessante. A transformada do tom puro só existe se o sinal sempre existiu - desde o começo dos tempos...

Se ligarmos um medidor e ele realizar o algoritmo da transformada, o sinal equivalerá não ao tom puro, mas ao sinal multiplicado pela função porta - afinal teremos de desligar o medidor em alguma hora.

Então o que temos na realidade no medidor não é a medição do tom puro, mas uma medição que quanto mais tempo ficar ligada irá se aproximar da do tom puro.

Isso é filosoficamente muito interessante: se tivermos um tom real que exista desde o começo dos tempos teremos na nossa medição apenas uma versão que terá início e fim - portanto não será vista como um tom puro.

Alternativamente, se o nosso tom que pensamos ser puro tiver tido um começo e fim, ao medirmos o mesmo com nosso medidor em uma janela de tempo menor não conseguiremos afirmar pela medição se o tom é realmente puro ou teve um início e terá um fim.

Esta percepção indica que mesmo em um domínio matemático bem definido, o que percebemos por realidade pode na verdade ser um quadro incompleto da mesma - só que nossas medições não terão o poder de dizer se é isto que está acontecendo ou não...

Profundo, não?

Há algumas coisas curiosas sobre a transformada de Fourier e freqüências puras. Pela transformada é possível verificar que só é possível obter um sinal de frequência pura (tom único). Em termos práticos, um sinal:

Terá a transformada uma soma de deltas de Dirac:

Mas um sinal que comece a partir de t=0 e não termine nunca.

terá uma transformada com os deltas e mais um conteúdo espectral adicional.

Mas esta não é a coisa extraordinária. O extraordinário é que um sinal que comece em em um certo t0 e termine em algum tempo no futuro:

Aonde rect á função porta. Terá a transformada:

Então vem a dúvida óbvia: como a transformada "sabe" que o sinal começou em t=0 e se desliga em algum tempo futuro? A resposta é clara na definição da transformada: ela abrange todo o passado e todo o futuro.

Então por isso poderia se pensar que a transformada não tem aplicações práticas. Bem, isto é um equívoco. A transformada em si teria várias limitações nas aplicações práticas, mas uma variante desta (a transformada rápida de Fourier) tem múltiplos usos.

No fundo há pouco interesse em se é uma ou outra utilizada, já que via de regra os resultados são similares.

Mas é a filosofia da coisa que é realmente interessante. A transformada do tom puro só existe se o sinal sempre existiu - desde o começo dos tempos...

Se ligarmos um medidor e ele realizar o algoritmo da transformada, o sinal equivalerá não ao tom puro, mas ao sinal multiplicado pela função porta - afinal teremos de desligar o medidor em alguma hora.

Então o que temos na realidade no medidor não é a medição do tom puro, mas uma medição que quanto mais tempo ficar ligada irá se aproximar da do tom puro.

Isso é filosoficamente muito interessante: se tivermos um tom real que exista desde o começo dos tempos teremos na nossa medição apenas uma versão que terá início e fim - portanto não será vista como um tom puro.

Alternativamente, se o nosso tom que pensamos ser puro tiver tido um começo e fim, ao medirmos o mesmo com nosso medidor em uma janela de tempo menor não conseguiremos afirmar pela medição se o tom é realmente puro ou teve um início e terá um fim.

Esta percepção indica que mesmo em um domínio matemático bem definido, o que percebemos por realidade pode na verdade ser um quadro incompleto da mesma - só que nossas medições não terão o poder de dizer se é isto que está acontecendo ou não...

Profundo, não?

terça-feira, 1 de fevereiro de 2011

Entrega do Manifesto em fotos

Como todos podem ver, fomos algo entre 80 e 120 pessoas (desconfio que foram 100 pessoas)

Post Scriptum: Contei agora 92 pessoas na foto panorâmica. Contando com o pessoal que não apareceu na foto deve dar mesmo perto de 100.

Invasão da Reitoria pelo ENE?

Nope, não foi invasão, foi uma manifestação para entregar uma carta ao reitor pedindo o cumprimento dos compromissos. No fundo era para ser uma coisa rápida, mas infelizmente acabou demorando mais do que o esperado.

A manifestação terminou quando o reitor assinou o UnBDoc que tratava dos compromissos pendentes. Só isto.

Bem, nem só isto... Como o reitor demorou a chegar a manifestação serviu de elemento catártico para várias pessoas. Isso foi bom para as pessoas e para o grupo, mas não tão maravilhoso para os objetivos originais (que felizmente acabaram sendo cumpridos).

A minha posição foi esta:

Mas de olhos mais abertos, hehehe

A manifestação terminou quando o reitor assinou o UnBDoc que tratava dos compromissos pendentes. Só isto.

Bem, nem só isto... Como o reitor demorou a chegar a manifestação serviu de elemento catártico para várias pessoas. Isso foi bom para as pessoas e para o grupo, mas não tão maravilhoso para os objetivos originais (que felizmente acabaram sendo cumpridos).

A minha posição foi esta:

Mas de olhos mais abertos, hehehe

Assinar:

Postagens (Atom)